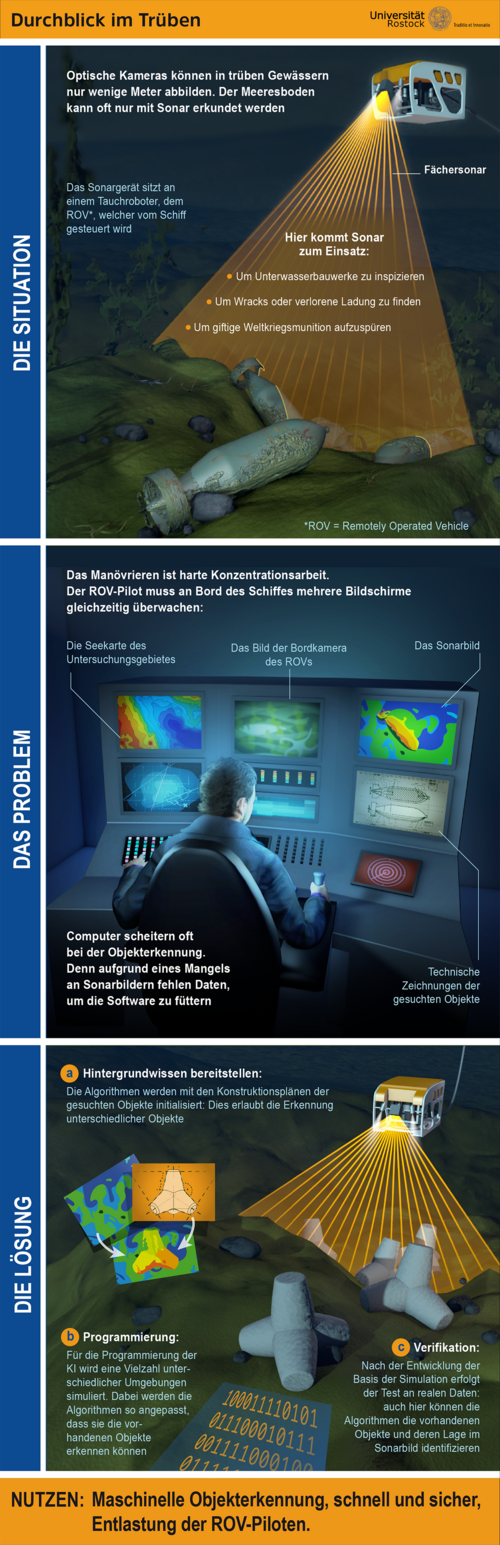

Die Inspektion von Unterwasserbauwerken wie etwa Windradfundamenten oder Trafostationen am Meeresboden kann anstrengend sein. Zwar nutzt man dafür heute ferngesteuerte Unterwasserfahrzeuge, die über Kabel mit einem Schiff verbunden sind. Doch für die Piloten, die diese Remotely Operated Vehicles (ROV) vom Schiff aus steuern, ist das Manövrieren harte Konzentrationsarbeit. Vor allem, weil sie gleich mehrere Bildschirme im Blick behalten müssen – das Bild der Bordkamera des ROVs, das Bild des Echolots, des sogenannten Sonars, das die Tiefeninformation zeigt oder auch die digitale Seekarte, auf der das Untersuchungsgebiet zu sehen ist. Hinzu kommen technische Zeichnungen der Objekte, nach denen die Piloten gerade suchen – etwa die Gehäuse von Unterwassertrafos, die repariert werden müssen. Die Bildschirmarbeit ist auch deshalb anstrengend, weil das Schiff und die Kamerabilder im Rhythmus der Wellen schwanken und weil die Piloten oft in abgedunkelten Räumen arbeiten. Manch einer wird davon seekrank.

Ein internationales Team um den Informatiker Sebastian Bader vom Institut für Visual and Analytic Computing der Universität Rostock arbeitet daran, den ROV-Piloten die Arbeit zu erleichtern. Die Gruppe entwickelt Algorithmen, die in Zukunft selbständig Objekte am Meeresgrund erkennen werden. „Das Problem besteht darin, dass man mit einer normalen Kamera in relativ trüben Gewässern wie der Nordsee oder Ostsee nur wenige Meter weit gucken kann“, sagt Sebastian Bader. „Um größere Bereiche zu überblicken, nutzt man daher die Bilder von Sonaren, die den Meeresboden mit Schallimpulsen abtasten und deutlich weiter reichen. Bislang sind Computer aber nicht besonders gut darin, in Sonarbildern Objekte zu erkennen – schon gar nicht in Echtzeit.“

In der Regel kommen heute für die Unterwasserarbeit Fächerecholote zum Einsatz. Anders als das klassische Echolot der U-Boote aus dem Zweiten Weltkrieg geben diese nicht einzelne Schallimpulse ab, die von Gegenständen in der Tiefe reflektiert werden. Vielmehr schickt ein Fächerecholot zeitgleich mehrere hundert Impulse in verschiedenen Winkeln hinab. Wie mit einem Fächer scannt es dabei nach und nach ganze Streifen des Meeresbodens ab. So entsteht ein 3D-Bild, ein Relief des Meeresbodens. Verschiedene Tiefen werden darin in unterschiedlichen Farben dargestellt. Menschen sind sehr gut darin, in diesen bunten Sonarbildern Gegenstände zu erkennen, die vom Meeresboden aufragen, etwa die Umrisse eines Containers, der über Bord gegangen ist oder das Wrack eines abgestürzten Flugzeugs. Für einen Computer aber ist eine solche Aufnahme zunächst nichts weiter als eine chaotische dreidimensionale Punktwolke. Für Informatiker wie Sebastian Bader besteht die Aufgabe darin, den Algorithmen beizubringen, die verschiedenen Objekte im Sonarbild zu erkennen.

„Für die Welt über Wasser nutzt man heute meist Neuronale Netze, die man mit Bildern von Objekten trainiert“, sagt Sebastian Bader. Füttert man ein Neuronales Netz zum Beispiel mit Tausenden von Katzenbildern, lernt es, wie Katzen aussehen. Nach dem Training kann es dann zielsicher Katzen auf Fotos identifizieren. „Für die Unterwasserwelt und vor allem für Sonarbilder aber gibt es bis heute einfach kaum Daten, mit denen man Neuronale Netze trainieren könnte“, sagt der Forscher. „Vermutlich verfügen das Militär und die Marine weltweit über solche Datensätze. Diese sind aber nicht öffentlich.“

Angesichts des Mangels an Trainingsdaten haben sich Sebastian Bader und sein Team für eine andere Lösung entschieden. Sie füttern ihre Algorithmen mit den Konstruktionszeichnungen verschiedener Objekte – Trafogehäusen, den Stahlstrukturen von Windradtürmen, mit Netzwerken von Unterwasser-Stromkabeln und vielem mehr. Die Algorithmen sind darauf getrimmt, Wahrscheinlichkeiten zu berechnen. Sie analysieren das Sonarbild, indem sie die vielen eingespeicherten Konstruktionszeichnungen miteinander vergleichen. Sie berechnen, um welchen Gegenstand es sich mit größter Wahrscheinlichkeit handelt. „Letztlich stellt der Algorithmus nacheinander Hypothesen über Gegenstände auf, mit denen sich die 3D-Form eines Sonarbilds erklären lässt“, sagt Bader. „Er verwirft die Hypothesen so lange, bis er jenen Gegenstand gefunden hat, der der 3D-Form am ehesten entspricht.“ Random sample consensus – RANSAC – heißt dieser klassische Ansatz der Wahrscheinlichkeitsrechnung. „Wir arbeiten auch mit Neuronalen Netzen. Die klassischen, auf Wahrscheinlichkeiten basierenden Verfahren scheinen in diesem Fall aber deutlich besser zu funktionieren.“

Der Mangel an Sonarbildern hat dem Team einiges an Kreativität abverlangt. So mussten die Informatiker zunächst Experimente in der virtuellen Welt durchführen – mit dem Simulationsprogramm „HoloOcean“ wurden mögliche Einsatzszenarien nachgestellt. Mit HoloOcean lassen sich realitätsnahe Sonarbilder eines virtuellen Meeresbodens erzeugen – und in diese dann gewissermaßen künstliche Gegenstände implantieren. Im ersten Schritt erzeugten die Informatiker also ein künstliches Sonarbild, welches Sonar-Reliefs von Tetrapoden enthielt – vierarmigen Wellenbrechern aus Beton, die auch an der Ostsee für den Küstenschutz genutzt werden. Nach einigem Programmieren konnten die Algorithmen die Tetrapoden schließlich im virtuellen Bild erkennen.

Der Realitätscheck folgte vor zwei Monaten. „Das Fraunhofer-Institut für Graphische Datenverarbeitung hier in Rostock hat uns dafür reale Sonarbilder zur Verfügung gestellt, auf denen echte Tetrapoden am Grund der Ostsee zu sehen sind“, sagt Sebastian Bader. Auch in diesem Fall klappte es. Die Algorithmen identifizierten die Tetrapoden im echten Sonarbild sofort. Bader: „Da ging ein Jubeln durch unser Labor.“

In den kommenden Monaten sollen die Algorithmen mithilfe weiterer echter Sonaraufnahmen weiterentwickelt werden. Diese Bilder werden im „Digital Ocean Lab“ bei Warnemünde aufgenommen. Beim Digital Ocean Lab handelt es sich um einen Unterwasserpark, in dem neben den Tetrapoden noch verschiedene andere Gegenstände wie zum Beispiel Natursteine oder Betonringe am Meeresboden installiert sind. Das Fraunhofer-Institut testet hier seine Unterwassertechnik. Das Digital Ocean Lab wird aktuell im Rahmen des Ocean Technology Campus Rostock erweitert: Künftig sollen dort neue Daten in ganz verschiedenen Forschungsprojekten erhoben werden. „Unser Fernziel ist, dass ROVs mithilfe unserer Algorithmen künftig ganz allein Gegenstände unter Wasser entdecken und inspizieren“, sagt Bader. „Im ersten Schritt aber wollen wir die ROV-Piloten bei ihrer anstrengenden Suche nach Gegenständen entlasten.“ Nicht zuletzt bei der Suche nach giftiger Munition aus dem Zweiten Weltkrieg am Grund der Ostsee.

Kontakt:

Dr. Sebastian Bader

Universität Rostock

Institut für Visual and Analytic Computing

Lehrstuhl Mobile Multimedia Information Systems (Prof. Thomas Kirste)

Tel.: +40 381 498 7518

sebastian.baderuni-rostockde